Avagy hogyan szűri a közösségi média a tartalmakat? (1. rész)

Régóta nem titok, hogy a legnagyobb közösségi média platformok nem csak emberi munkaerőt használnak annak érdekében, hogy szűrjék a szolgáltatásukban található tartalmakat. A mesterséges intelligenciával rendelkező algoritmusok népszerűségének oka elsősorban az, hogy a nap minden egyes percében olyan mennyiségű tartalom kerül fel a legnépszerűbb platformokra, amelynek az áttekintéséhez nem áll rendelkezésre humán erőforrás.

A nagy techcégek – különösen a Facebook – megváltó technológiát látnak a mesterséges intelligenciában, ugyanakkor a problémás esetekben szívesen hivatkoznak annak nem megfelelő működésére a felelősség elhárítása érdekében. A szakértők ugyanakkor arra figyelmeztetnek, hogy ezek az eszközök még nem elég fejlettek ahhoz, hogy „szabadon lehessen őket engedni” a virtuális térben.

Friss blogbejegyzés sorozatunkban a népszerű közösségi média- és videómegosztó-platformok moderálási gyakorlatát fogjuk elemezni a véleménynyilvánításhoz való jog online érvényesülésének szemszögéből. Az első téma, amelyről szükséges részletesebben szólni az automatizált tartalomszűrés, hiszen a túlmoderálás a szólásszabadság online érvényesülésének egyik legnagyobb kockázata.

A Statista adatai alapján a legsűrűbben használt közösségi média platformok a következők: Facebook, YouTube, WhatsApp, Facebook Messenger, Instagram, WeChat, TikTok, QQ, Douyin, Sina Weibo, Telegram, Snapchat, Kuaishou, Pinterest, Reddit, Twitter és a Quora. Mivel jelen blogbejegyzés alapvetően a véleménynyilvánítás szabadságának érvényesülésére fókuszál, kizárólag azokkal az európai színtéren releváns platformokkal foglalkozunk, amelyek lehetőséget teremtenek arra, hogy a felhasználók szélesebb közönséget is elérjenek, a privát üzenetküldő szolgáltatásokkal nem foglalkozunk.

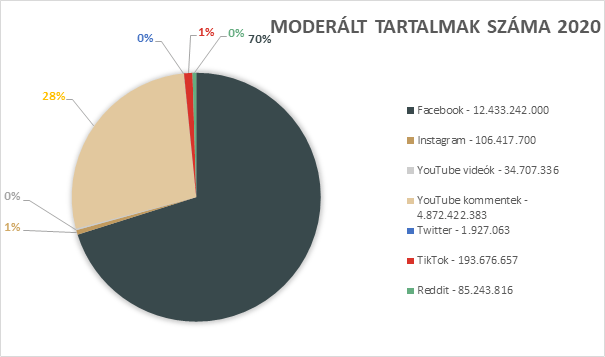

A vizsgált cégek átláthatósági jelentései egyértelműen azt mutatják, hogy 2020-ban a legnagyobb tartalommoderáló a Facebook volt. A cég ebben az évben több mint 12 milliárd tartalmat moderált (amelybe beletartoznak a posztok és a kommentek is). A többi vizsgált közösségi média platform moderálási gyakorlata ehhez képest visszafogott, az Instagram 106 millió, a fiatalok körében igen népszerű TikTok 193 millió, a YouTube 4,9 milliárd tartalom (ebből közel 35 millió videó és 4,7 milliárd komment) vonatkozásában élt moderálási tevékenységével.

Noha a számok alacsonyabbak, mint a Facebook esetében, milliós nagyságrendben már nem egyszerű feladat a tartalommoderálás. Ezt a YouTube példáján jól lehet érzékeltetni: ha minden eltávolított videóról feltételezzük, hogy 1 perc hosszúságú, akkor a cégnek a 2020-as évben 66 évnyi tartalmat kellett moderálnia (1 nap 1440 percből áll, tehát kb. 24 102 napot venne igénybe az összes moderált videó megtekintése). Ennél természetesen a napi moderálás során jóval több tartalmat kell megvizsgálni, hiszen sok olyan bejelentés is érkezik, ami alapján nem szükséges intézkedni.

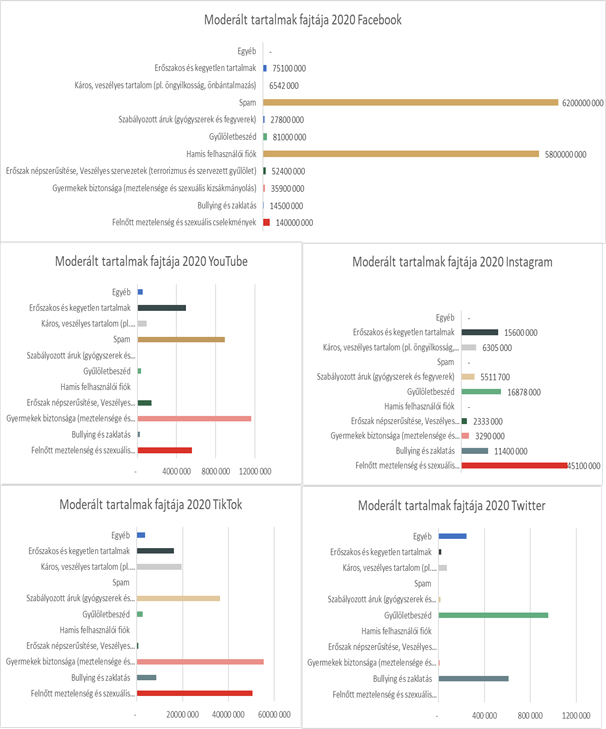

A legtöbb moderálás alá eső tartalmat a platformok azért távolították el, mert spamnek illetve hamis fióknak minősült. Ezeknek a profiloknak és üzeneteknek a károssága épp a tömegességben rejlik, így nem meglepő, hogy ezek nagy részt tesznek ki a moderált tartalmak között. Jelentős még a meztelen felnőttet és a szexuális cselekményeket bemutató moderált tartalmak száma. Ezek a tartalmak általában nem jogellenesek, viszont a Facebook, az Instagram, a YouTube és a TikTok a meztelenség minden formáját tiltják, azok a közösségi irányelveikbe ütköznek. Nagy mennyiségű tartalmat távolítanak el a vizsgált platformok a gyermekvédelmi szabályok, illetve a gyűlöletbeszéd tilalmára vonatkozó szabályok megsértése miatt is.

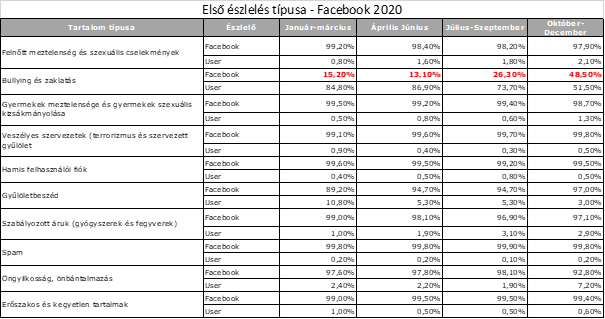

A platformok szerepe a moderálandó tartalmak azonosításában domináns, hiszen a moderált tartalmak többségét a szolgáltatók saját maguk észlelik és távolítják el (a Facebook és az Instagram esetében átlagosan 95% feletti az algoritmus által észlelt moderálandó tartalmak aránya). A felhasználók által észlelt tartalmak száma elenyésző, a Facebookon egyedül a zaklatás esetében magasabb, mint a platform saját észlelése. Ez vélhetően annak köszönhető, hogy a zaklató jelleg megítélése sok esetben az egyén szubjektív érzékelésén alapul. A 2020-as év folyamán azonban itt fejlődött a legtöbbet a szolgáltató, hiszen az év végére már jóval magasabb arányban tudta kiszűrni a zaklató tartalmakat.

Hasonló számokat láthatunk a YouTube esetében, ahol a 34 707 336 moderált tartalom nagy részét, 32 752 265 tartalmat az algoritmus szűrt ki.

A moderált tartalmak száma tehát minden platform esetében milliós nagyságrendű, a moderálást pedig a legtöbb esetben valamilyen algoritmus végzi. Joggal merül fel azonban a kérdés, hogy mennyire működnek megbízhatóan ezek a megoldások, főként, amikor olyan esetekről hallunk, hogy a Facebook algoritmusa tévedésből törölte a Függetlenségi Nyilatkozatot, vagy a YouTube az algoritmus pontatlanságai miatt elkezd több emberi moderátort alkalmazni.

A sorozat következő része azt a kérdést járja körbe, hogy hány esetben derülnek ki az algoritmusra alapozott döntéshozatal hibái, illetve milyen eséllyel kerülhet vissza egy már eltávolított tartalom a szolgáltatásba.